DifyでLM Studio経由のEmbeddingモデルを設定(RAGで使用)

RAGとは

チャットボットの画面で、独自のデータを与えてそこから回答をさせることができます。

例えば、FAQのテキストが入ったPDFを用意して、チャットボットの回答はそのFAQデータから行わせることができます。

Difyで扱える独自のデータは下記のようになっています。

その仕組みは

RAG(検索拡張生成:Retrieval-Augmented Generation)

という技術です。Difyで使えるようになっています。

Embeddingモデルとは

RAGで検索できるようにするためには、独自のデータをLLMが扱いやすい形(数値ベクトル)に変換(ベクトル化)する必要があります。

その変換の仕組みはEmbedding(埋め込み表現)という技術です。

このEmbeddingをする処理は、Embeddingモデルで行うことができます。

LM StudioにEmbeddingモデルを持たせることによって、まずはDifyでEmbeddingモデルの登録をする手順を紹介いたします。

使用するEmbeddingモデルは、定評のあるオープンソースの下記モデルとします。

提供会社名:Nomic

ライセンス:Apacheライセンスバージョン2.0

https://huggingface.co/nomic-ai/nomic-embed-text-v1.5

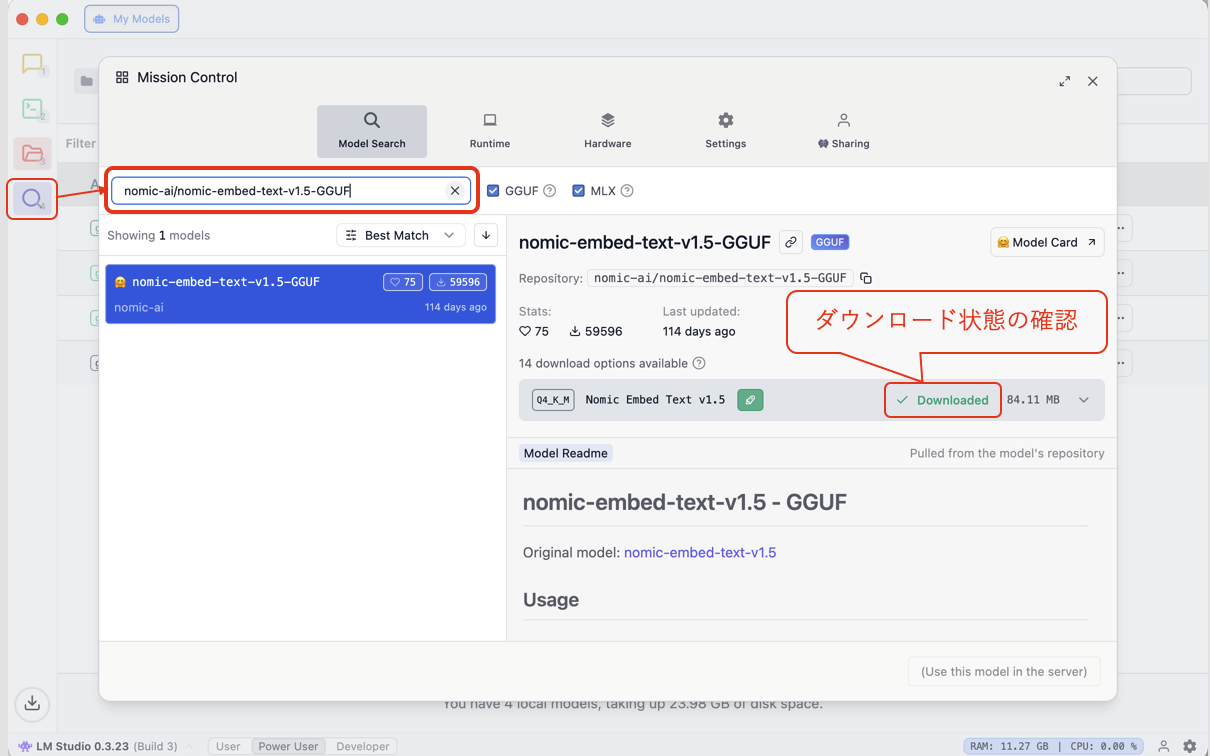

1.LM StudioでEmbeddingモデルの存在確認

- LM Studioを起動して、左メニューの虫眼鏡アイコンの「Discover」をクリックします。

- 検索窓に

nomic-ai/nomic-embed-text-v1.5-GGUFと入力して検索します。

図. Embeddingモデルを検索してダウンロードの状況を確認 「Downloaded」の表示の場合は、すでにLM StudioにEmbeddingモデルが入っていることになります。

「Download」の表示の場合は、クリックしてダウンロードを進めます。

※当方の環境では、LLMモデルの「gpt-oss-20」「gemma3:12b」等をインストールしていた状態では、すでにインストールされている状態になっておりました。

2.DifyのモデルプロバイダーでEmbeddingモデルを追加

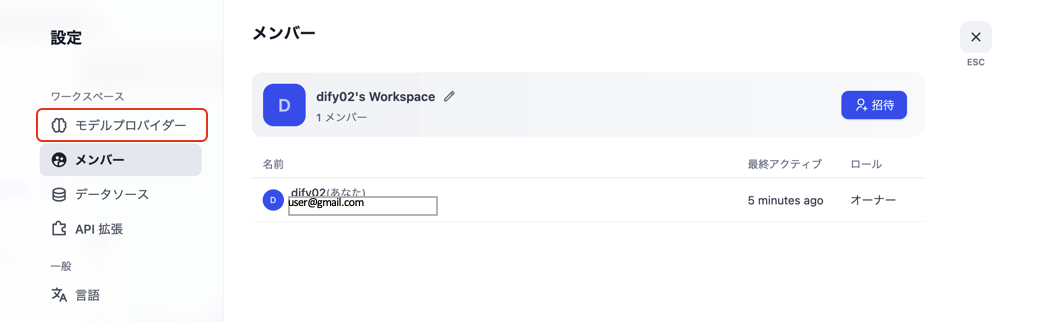

- Difyを起動し、ログインします。

- 画面右上の プロフィールアイコン をクリックします。

- 表示されたメニューから 「設定」 を選択します。

- 左側メニューから 「モデルプロバイダー」 をクリックします。

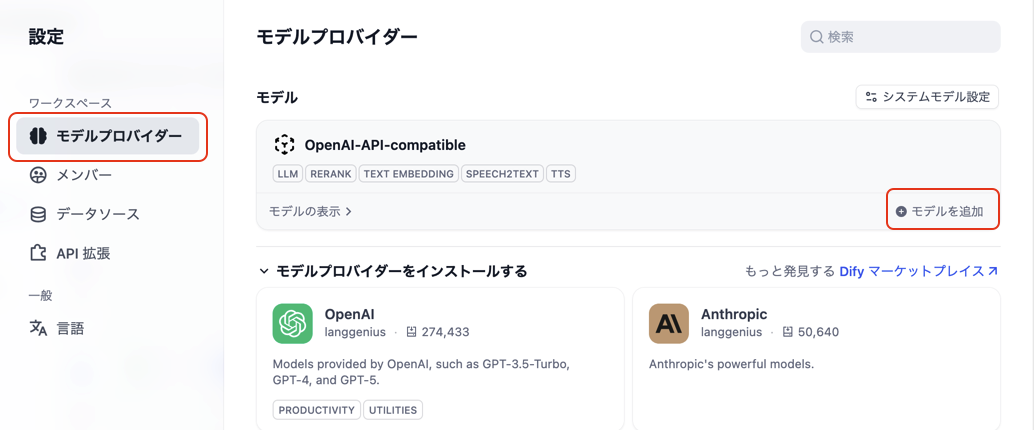

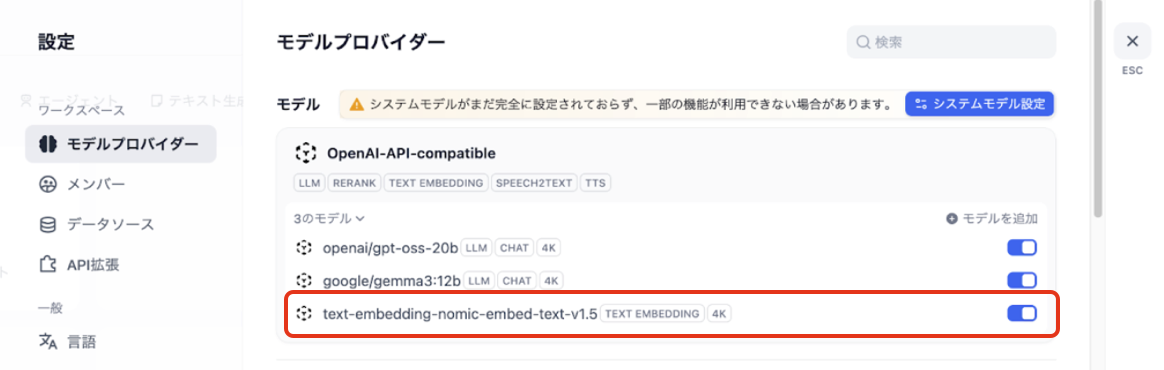

図. 左側メニューから 「モデルプロバイダー」 をクリック - 「OpenAI-API-compatible」の「モデルを追加」をクリックします。

図. 「OpenAI-API-compatible」の「モデルを追加」をクリック

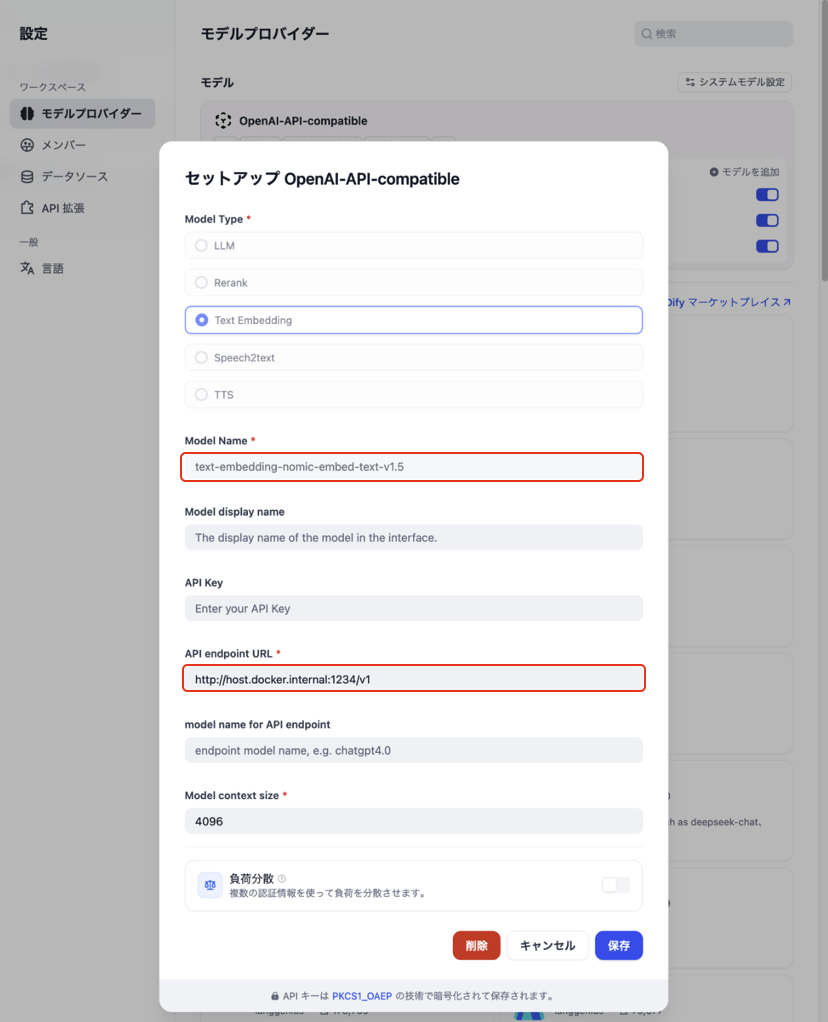

3.Embeddingモデルの接続情報を入力して保存

-

項目 選択・入力する内容 備考 Model Type Text Embedding Embeddingモデルとしての登録になるので、「Text Embedding」が選択された状態にします。 Model Name text-embedding-nomic-embed-text-v1.5API endpoint URL

(dockerでローカル起動の場合)http://host.docker.internal:1234/v1固定値として反映します。

LM Studioはローカルポート1234でAPIサービスを開始します。この表を参考に入力して、「保存」ボタンをクリックします。

図. モデルの接続情報を入力 -

「モデルを表示」をクリックしたときに、設定したモデルが表示されていれば設定は成功です。

図. 設定したモデルを確認

Categorys : ローカル LLMとの連携