DifyでLM Studio経由のローカルLLMを設定

DifyでLM Studio経由のローカルLLMを設定する場合の手順を紹介いたします。

前提は

- ローカル環境(メモリは32GB以上を推奨)にLM Studioをインストールしている。

- LM StudioでローカルLLMのモデル「openai/gpt-oss:20b」をインストールしている。

参考記事:LM Studioの導入 - Difyをローカル環境で起動している。

としています。

※他のモデルを設定の場合は、モデル名を読み替えていただければと思います。

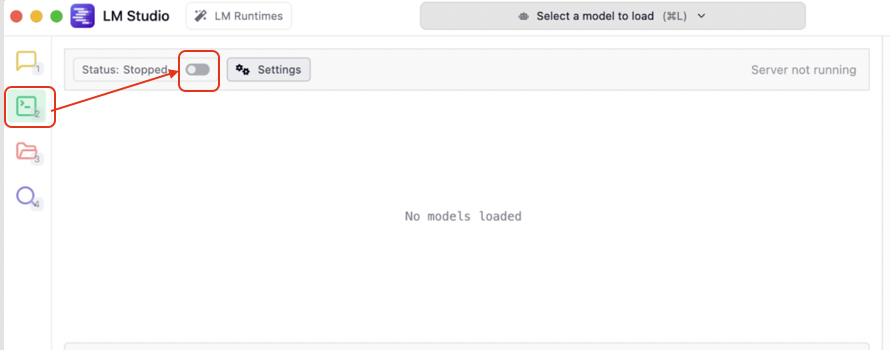

1.LM Studioをサーバーとして起動

- LM Studioを起動して、左メニューの緑色アイコンの「Developer」をクリックします。

画面の上部にAPIサーバー起動用のトグルボタンがあります。

図. LM Studioで「Developer」をクリック - サーバー起動用のトグルをクリックします。

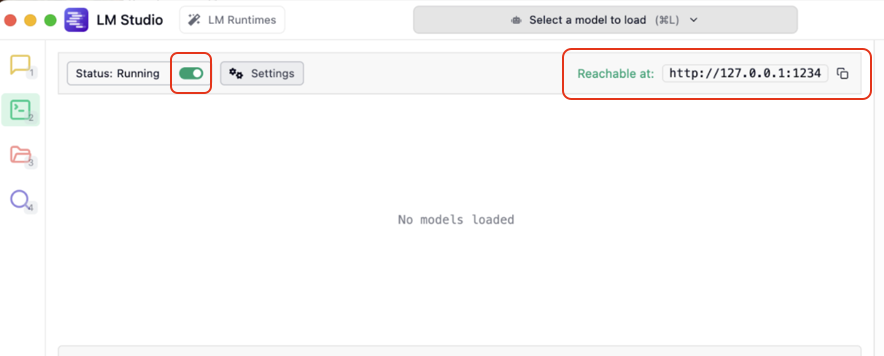

トグルがONの状態になって、右側に起動していることを示すサーバーのアドレスが表示されます。

図. LM StudioをAPIサーバーとして起動

2.Difyの設定画面にアクセス

- Difyを起動し、ログインします。

- 画面右上の プロフィールアイコン をクリックします。

- 表示されたメニューから 「設定」 を選択します。

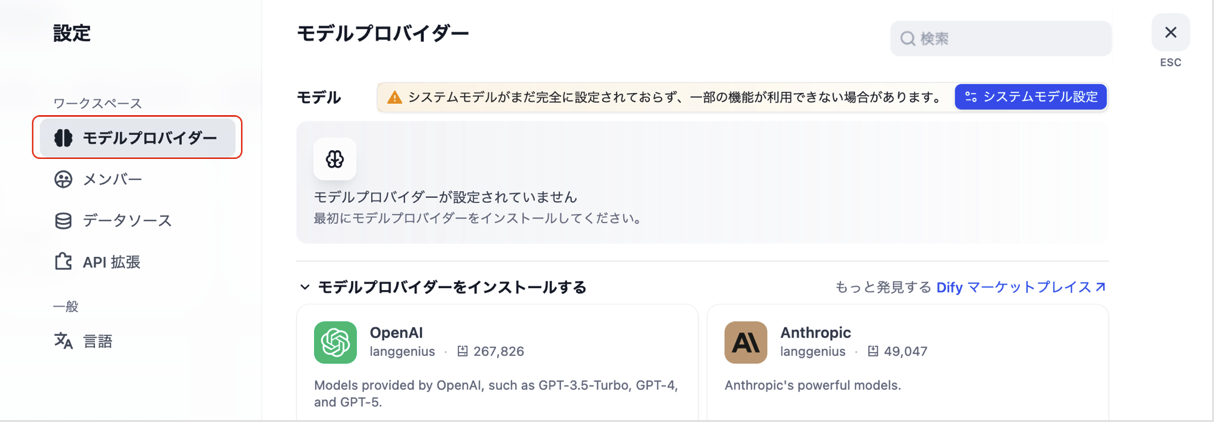

図. プロフィールのメニューから 「設定」 を選択 - 左側メニューから 「モデルプロバイダー」 をクリックします。

図. 左側メニューから 「モデルプロバイダー」 をクリック

3.「OpenAI-API-compatible」をモデルプロバイダーとして追加

- 「モデルプロバイダー」画面で 「OpenAI-API-compatible」 を選択します。

図. 「モデルプロバイダー」画面で 「OpenAI-API-compatible」 を選択 ※プラグインの「LM Studio」は存在しているのですが、2025年8月時点ではインストールが失敗しやすく、

Visionの設定(マルチモーダルの有効化)ができない問題があります。

そのため、ここでは別のプラグイン「OpenAI-API-compatible」 の使用としております。

図. プラグインの「LM Studio」(2025年8月時点) - 「インストール」ボタンをクリックします。

図. 「インストール」ボタンをクリック - 「モデルを追加」ボタンをクリックします。

図. 「モデルを追加」ボタンをクリック

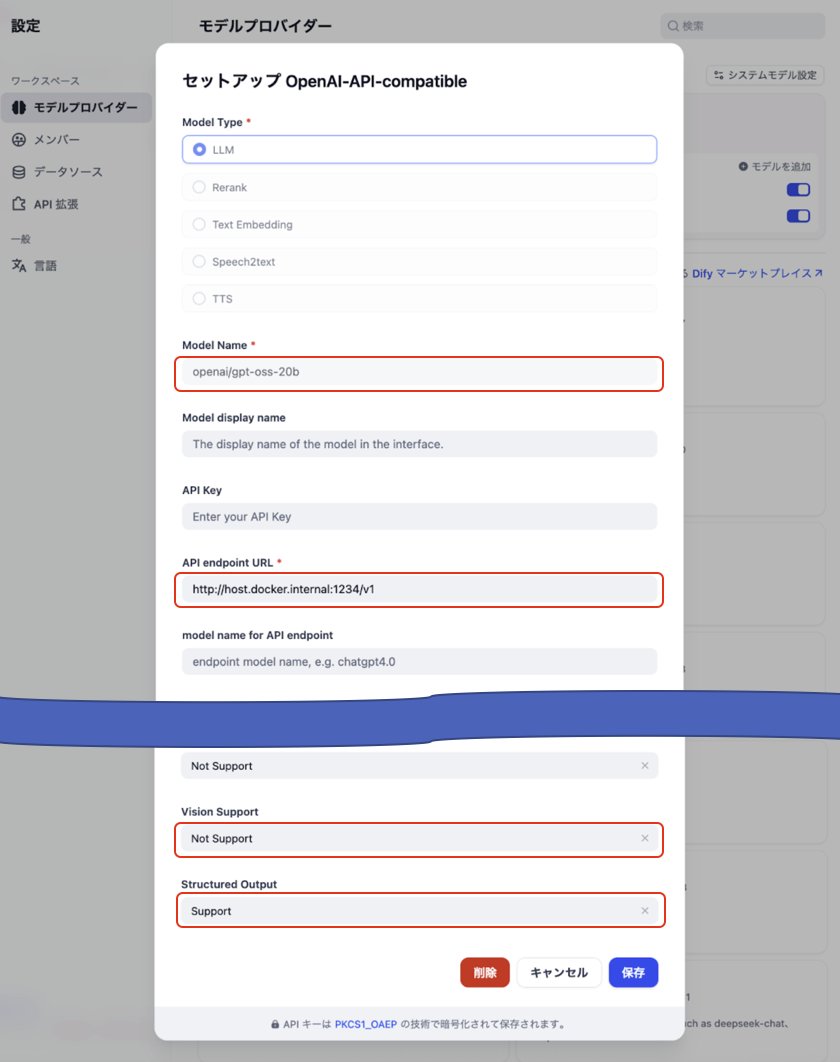

4.LLMモデルの接続情報を入力して保存

- LLMモデルの接続情報を入力します。

項目 選択・入力する内容 備考 Model Type LLM LLMモデルとしての登録になるので、「LLM」が選択された状態にします。 Model Name 実モデル名

例:

openai/gpt-oss-20bLM Studioでインストールしたモデル名を入力します。

正確なモデル名はLM Studioの「My Models」の画面(インストールしたモデル一覧)で確認します。

参考記事:LM Studioの導入 モデルの追加と確認API endpoint URL

(dockerでローカル起動の場合)http://host.docker.internal:1234/v1固定値として反映します。

LM Studioはローカルポート1234でAPIサービスを開始します。Vision support マルチモーダル対応の場合は「Support」 「google/gemma3:4b」「google/gemma3:12b」等の

マルチモーダル(画像分析)対応の場合はSupportにします。Structured Output 「Support」または「Not Support」 ノードの「出力変数」で構造化出力を使用時に必要になるため、Supportにします。 ワークフロー等で、LLMのシステムプロンプトの中でJSONフォーマットの出力指定をする場合は、設定が「Support」の場合にエラー(例:Error: API request failed with status code 400: {\”error\”:\”‘response_format.type’ must be ‘json_schema’ or ‘text’\)になる場合があります。(OpenAI-Compatible APIに「Response Format」で「json_object」設定の項目が無い等も影響する場合有り)この場合、設定は「Not Support」とする必要があります。

この表を参考に入力して、「保存」ボタンをクリックします。

図. モデルの接続情報を入力 - 「モデルを表示」をクリックしたときに、設定したモデルが表示されていれば設定は成功です。

図. 設定したモデルを確認

関連記事

Categorys : ローカル LLMとの連携