ローカルLLM 実行環境

2025年08月15日(金) 23:54:11

ローカルLLMの実行環境としては、「LM Studio」「Ollama」が有力候補と考えております。

下記の表は当方が2025年8月で想定している「LM Studio」「Ollama」との比較表です。

※mac CPU:Apple Silicon メモリ32GBで確認しました。

比較項目

LM Studio

Ollama

確認バージョン

バージョン:0.3.23

リリース日:2025年8月

バージョン:0.11.4

リリース日:2025年8月

メリット

Ollamaよりもモデル ...続きを読む

2025年08月15日(金) 21:05:17

https://lmstudio.ai/download

の画面でLM Studioのダウンロードを行います。

OSのプルダウンで「macOS」「Windows」「Linux」のいずれかを選択します。

次のrunningで種類を選択します。

※ macOSの場合は「M series」のみ選択可能(Intel版は提供されておりません。)

※ Windowsの場合は「x86」「ARM64(Snapdragon)」が選択可能

macOSの場合は「Download for macOS」のボタンをクリックでダウンロードになります。

Windowsの場合は「Downl ...続きを読む

2025年08月15日(金) 20:34:46

LM Studioは、大規模言語モデル(LLM)をローカル環境で実行できるオープンソースのプラットフォームです。

アメリカの会社「Element Labs」が提供しています。

Mac(Apple Siliconのみ)、Windows、Linuxに対応しており、

https://lmstudio.ai/download

でインストール後は、グラフィカルユーザーインターフェース(GUI)の画面で下記のような機能が使用可能になっています。

ローカルLLMのインストール

チャットとしての利用

サーバーとしての起動とログ表示

関連記事

ローカルLLM ...続きを読む

2025年08月11日(月) 14:36:09

Ollama(オラマ)は、大規模言語モデル(LLM)をローカル環境で実行できるオープンソースのプラットフォームです。

アメリカの会社が提供しています。

Mac、Linux、Windowsに対応しており、

https://ollama.com/download

でインストール後は、

コマンドプロンプトで動作をさせることができます。

図. Ollamaのコマンドプロンプトのイメージ

2025年7月30日には、Windows/Mac対応の新しいデスクトップアプリが追加されました。

図. Ollamaのデスクトップアプリ

...続きを読む

2025年08月11日(月) 13:42:33

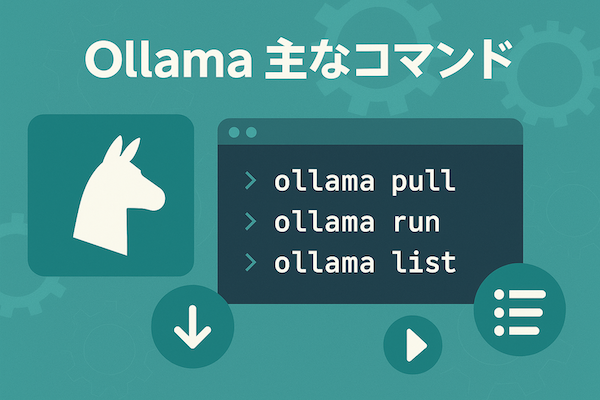

下記の表は、

https://ollama.com/download

でollamaをインストールしたときに使える主なコマンド集です。

macOSの場合:ターミナルを起動

Windowsの場合:PowerShellを起動

の画面で使用します。

実行内容

コマンド

備考

ollamaのバージョン

[copycode]ollama --version[/copycode]

コマンドは「ollama -v」も使用可能。

モデルのインストール

[copycode]ollama pull [モデル名][/copycode]

...続きを読む